Meta, l’entreprise derrière l’assistant Meta AI, a récemment dévoilé les deux premiers modèles de la famille Llama 3 : Llama 3 7B et Llama 3 70B. Ces modèles, déjà intégrés dans l’assistant Meta AI sur les réseaux sociaux anglophones, marquent une avancée significative dans le domaine de l’intelligence artificielle.

Des Modèles Puissants

Les Llama 3 sont des modèles linguistiques open source dotés de capacités impressionnantes. Voici ce que nous savons sur ces deux premiers membres de la famille :

- Llama 3 7B : Ce modèle est équipé de 7 milliards de paramètres. Meta affirme qu’il s’agit du meilleur modèle de sa catégorie. Comparé à son prédécesseur, Llama 2, il offre des taux de faux refus réduits, un alignement amélioré et une plus grande diversité de réponses. De plus, Llama 3 présente des capacités de raisonnement et de génération de code optimisées.

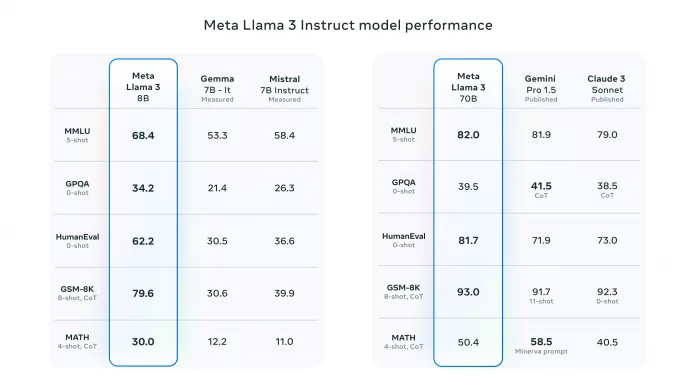

- Llama 3 70B : Ce modèle est encore plus puissant, avec 70 milliards de paramètres. Il rivalise avec les meilleurs modèles existants. Meta a comparé ses performances avec Gemma de Google, Mistral 7B de Mistral AI, Gemini Pro 1,5 de Google et Claude 3 Sonnet d’Anthropic.

Données d’Entraînement Massives

L’une des clés du succès des Llama 3 réside dans leur ensemble de données d’entraînement. Le corpus totalise plus de 15 téraoctets de jetons de données publiques, soit sept fois plus que celui de Llama 2. Il couvre plus de 30 langues, dont certaines ne sont pas anglaises. Meta reconnaît que les performances peuvent varier selon la langue, mais la qualité reste élevée.

Architecture et Optimisation

Meta a apporté des améliorations architecturales aux Llama 3. Ils utilisent un tokenizer avec un vocabulaire de 128 000 jetons, ce qui améliore l’encodage du langage. De plus, l’approche d’attention des requêtes groupées (Group Query Attention ou GQA) a été mise en œuvre pour les versions de 8B et 70B. Les modèles ont été entraînés sur des séquences de 8192 tokens, avec un masque spécifique pour limiter l’attention aux frontières du document.

Disponibilité Future

Les deux modèles seront bientôt disponibles sur des plateformes telles que AWS, Databricks, Google Cloud, Hugging Face, Kaggle, IBM WatsonX, Microsoft Azure, NVIDIA NIM et Snowflake. De plus, Meta prévoit de lancer plusieurs modèles multimodaux dans les mois à venir, avec une prise en charge de plusieurs langues et des capacités globales plus robustes.

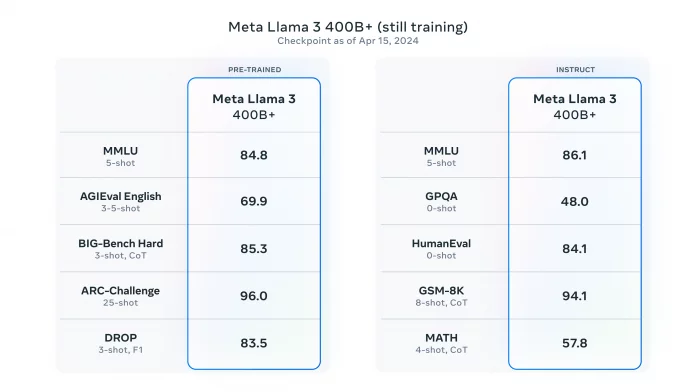

Enfin, un aperçu du plus grand modèle de la famille, Llama 3 400B, a été donné. Les poids de Llama 3 et le générateur de jetons sont téléchargeables sur GitHub.

Leave a Reply